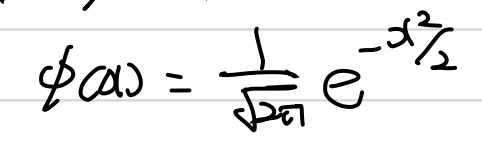

X1,...,Xn이 평균을 μ, 분산을 σ^2 으로 지니는 i.i.d. 조건 분포에서 random sampling(independent trials)되었다고 생각해보자.Sn = X1+X2+...+Xn, An = (Sn)/n 이다.이 때, 이전까지 증명했던데로 다음의 2가지는 자명한 사실이다. 1. E(An) = μ2. n을 무한으로 늘리면 An -> μ 그렇다면 An(Sn)의 분산은 매우 큰 n에 대해 어떻게 변하게 될까?더보기1. Ø(x) : x를 가지는 standard Normal density function.2. NA(a*,b*) = Ø(x)를 a*~b* 구간에서 적분한 값.9.1. Central Limit Theorem for Bernoulli trials성공 확률이 p인 베르누이 시행은 Sn ..